Zien is niet meer geloven

Neppe pornovideo’s of politici alles laten doen en zeggen wat je wilt; het kan allemaal en wordt steeds makkelijker. Deepfake technologie is een handige tool voor trollen en misleiders, maar kan ook door bedrijven, kunstenaars en filmmakers worden ingezet. Wegen de kansen die deepfake technologie biedt op tegen de risico’s?

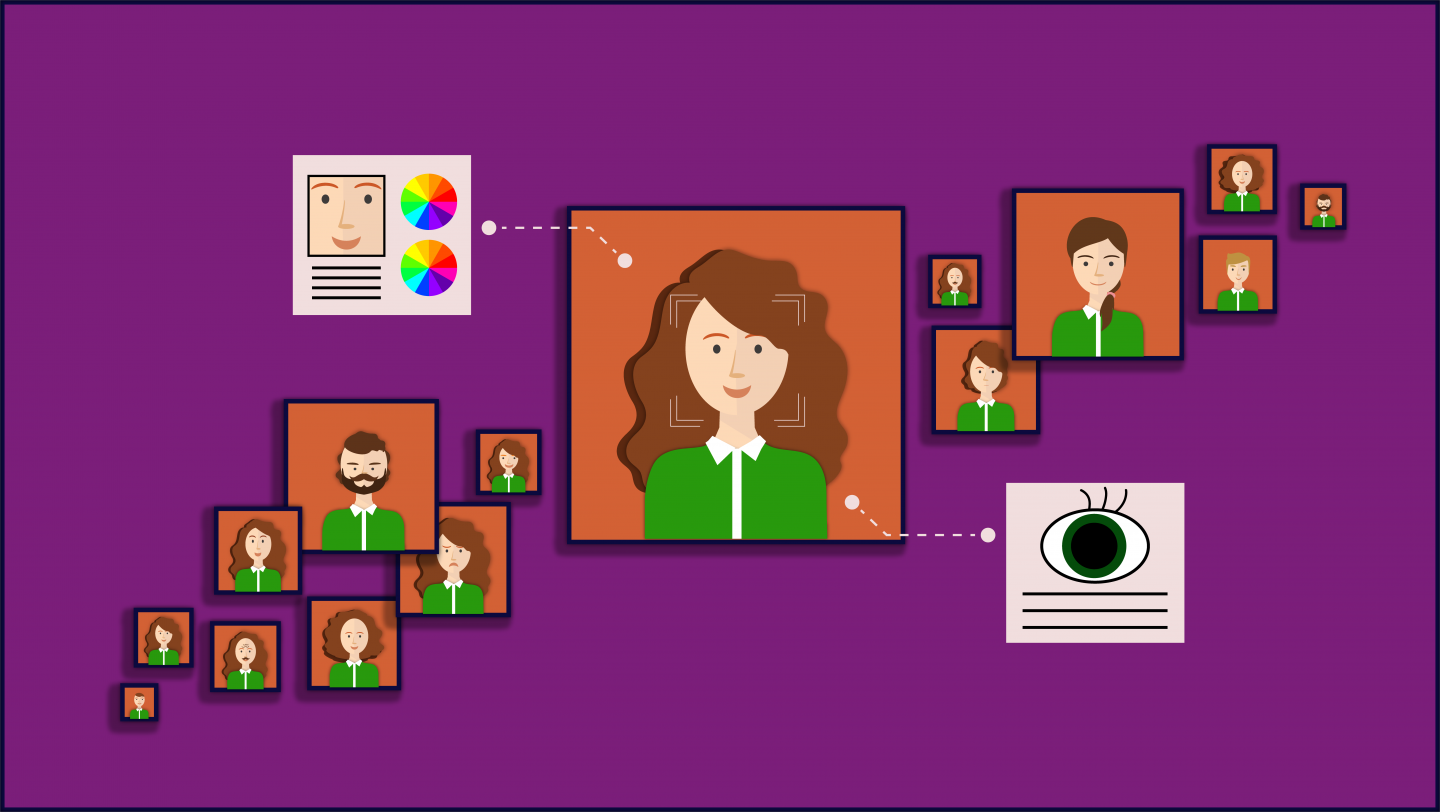

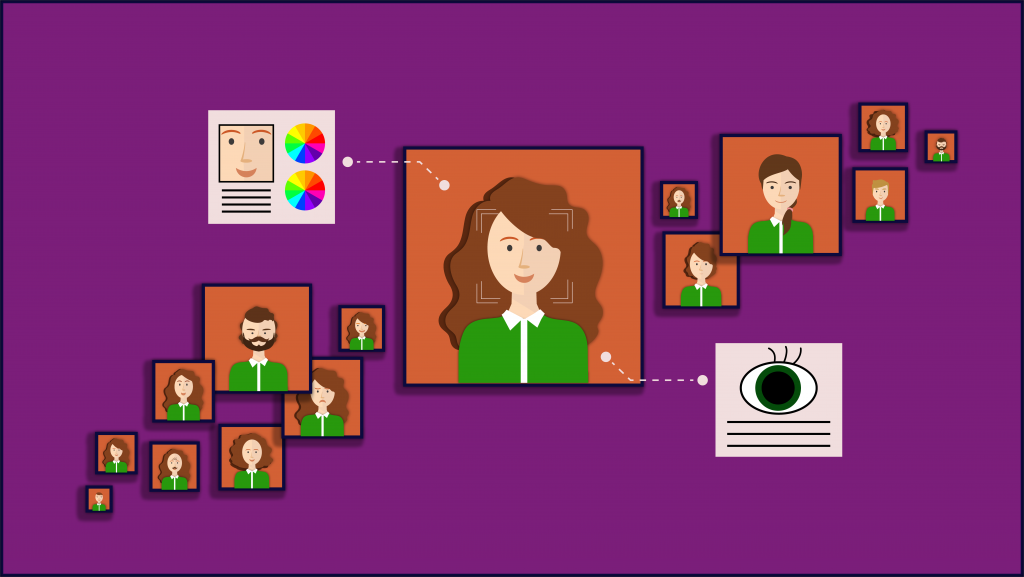

De naam deepfake is een combinatie van de woorden deep learning en fake. Het algoritme (in programmeertaal een instructie, een stukje code om een probleem om te lossen) achter deep learning is gebaseerd op patroonherkenning. De techniek zorgt ervoor dat computers nieuwe dingen kunnen leren op basis van grote hoeveelheden data. Als een algoritme zelf dingen kan leren, dan spreken we van kunstmatige intelligentie, oftewel AI. Wanneer je bijvoorbeeld het algoritme een aantal video’s van Donald Trump voedt, kan de AI op basis van het videomateriaal van de Amerikaanse president een nepvideo maken en voilà, je hebt een deepfake.

De deepfake-software maakt eigenlijk gebruik van twee AI’s, één die een nepvideo maakt en een die de video toets op zijn echtheid. Zo ontstaat er een cyclus waarin het ene algoritme weer leert van het andere, totdat de video bijna niet van echt te onderscheiden is.

Deepfake-software zet dus AI in om nepvideo’s te maken die echt lijken. Dit soort programma’s waren vroeger alleen toegankelijk voor propagandamakers van overheden of filmmakers in Hollywood, maar is nu steeds vaker gratis te downloaden en te gebruiken op je computer of op je telefoon.

https://vimeo.com/346386036

Digitale beeldenstorm

De deepfake-filmpjes laten zich nu nog vaak verraden door ogen die te weinig knipperen.

Volgens filosoof Elzie de Mul is het echter slechts een kwestie van tijd voordat deepfakes niet meer van echt te onderscheiden zijn. ”Met een groot wantrouwen ten opzichte van het beeld, is het wachten op een digitale beeldenstorm – dat we misschien wel moeten afstappen van het idee dat beelden waarheidsgetrouw zijn.”

Deepfakes worden vooral problematisch wanneer journalisten, waarvan we verwachten dat ze ons de feiten leveren, zelf niet meer de waarheid kunnen achterhalen, denkt de Mul. “Waarheidsvinding is nu al een opgave, maar zie maar eens iemand te geloven of te vertrouwen als realiteit en fantasie niet van elkaar te scheiden zijn.”

Hoe herken je een deepfake?

Letten op het knipperen van de ogen is dus één manier om een deepfake te herkennen. Maar volgens de organisatie Mediawijsheid kun je een nepvideo ook herkennen aan onnatuurlijke mondbewegingen, vervaagde pixels in het beeld en lichaamsgedragingen die niet kloppen met de bewegingen van het hoofd.

Daarnaast wordt het steeds belangrijker om bronnen te achterhalen. Is de afzender een bekende nieuwsbron zoals de NOS of is de afzender onbekend? Volgens de organisatie kan een onbekende bron een eerste aanwijzing zijn voor onbetrouwbaarheid. Ga ook na of de video op meerdere betrouwbare nieuws media is gepubliceerd. Bijvoorbeeld via DuckDuckGo en YouTube en kijk hoe de video daar wordt gepresenteerd.

It’s alive!

Je kan scenes aanpassen en beelden manipuleren, maar de technologie biedt ook positieve nieuwe mogelijkheden. Het Dali museum in St Petersburg demonstreerde deze mogelijkheden afgelopen mei, door Salvador Dali op een computerscherm museumgangers te begroeten en zelfs te laten praten over koetjes en kalfjes zoals het weer. En dat terwijl Dali al 30 jaar dood is.

Inmiddels is er een techniek ontwikkelt waarbij uit slechts een kort filmpje van een levend persoon later een deepfake gemaakt kan worden, zelfs als diegene al overleden is. De AI interpreteert de kenmerken van de gefilmde persoon, een stemacteur zit voor een webcam en doet de persoon na. De AI plakt dan als het ware een model van het hoofd van de gefilmde persoon op die van de stemacteur.

Maar wat doet het met ons rouwproces wanneer we via AI contact kunnen behouden met een representatie van onze geliefden nadat ze dood zijn gegaan? Documentairemaker Roshan Nejal doet daar onderzoek naar.

“Voor de documentaire heb ik toegang gekregen tot deze deepfake-techniek. Het is dus een samenwerking met wetenschappers en onderzoekers. Dat onderzoek is op dit moment nog geheim. We zijn de realiteit eigenlijk een stapje voor.” Vertelt Nejal. “Het bronmateriaal is als het ware een marionet en de acteur bestuurd die marionet. Op die manier kan je een soort skype-gesprek houden met je overledene dierbaren.”

Het klinkt misschien luguber, een vreemde die jouw dierbare bestuurd als een soort poppenspeler. Toch kan de potentiële therapeutische waarde hoog zijn. Bijvoorbeeld wanneer je iemand een laatste keer gedag wil zeggen, maar daar in het echt niet de kans voor kreeg. Of we in de toekomst bang moeten zijn voor deze mogelijkheden om deepfake in te zetten? Nejal denkt van niet; hij voorziet een toekomst waarin hele callcenters en redacties bestaan uit deze stemacteurs met hun webcams. “Als het ons steun en troost geeft – de gedachten dat we altijd met onze dierbare in contact kunnen komen en dat we een gesprek met ze kunnen hebben – in hoeverre maakt het dan uit dat het nep is?” Volgens hem gaat het niet om realistische, maar pragmatische waarde van de technologie. “Vergelijk het maar met het geloof; maakt het uit of god wel of niet bestaat als het ons steun geeft?”

Een helpende hand

Deepfakes hebben dus een mogelijk therapeutische waarde, maar de angst voor nepnieuws en misleiding blijft reëel. Het is daarom niet alleen aan onszelf om de nepvideo’s te herkennen. Soortgelijke algoritmes kunnen ook worden ingezet om de nepvideo’s te detecteren. Neem bijvoorbeeld het knipperen. Een AI kan voor dat soort doeleinden geprogrammeerd worden. Wanneer een video voor ons niet meer als nep aan te merken is, kan een AI tot in de diepste pixels en tot aan de milliseconden nog herkennen dat er iets niet aan het beeld klopt.

Theo Gevers, hoogleraar en oprichter van AI ontwikkelaarsbedrijf 3DUniversum houdt zich bezig met het ontwikkelen van dit soort echtheid detectie-software, maar hoe die werkt moet geheim blijven. “Anders wordt daar weer gebruikt van gemaakt om de nepvideo’s te verbeteren. Het is een kat en muis spel.” Zegt Gevers.

Daarnaast hebben wetenschappers van Khalifa University in Abu Dhabi een methode ontwikkeld om via ‘Blockchain’ en ‘Smart contracten’ altijd te kunnen achterhalen wat de bron van een video is. Een blockchain is een systeem dat gebruikt wordt om gegevens vast te leggen. En een smart contract is een digitale overeenkomst, die automatisch van kracht gaat wanneer er aan bepaalde omstandigheden wordt voldaan. Door de methode wordt de bronvermelding in de metadata van de video verwerkt en blijft die daar zitten ook wanner de video meerdere malen wordt gekopieerd.

Een ingewikkeld verhaal; het komt er op neer dat als betrouwbare nieuwsmedia overstappen op deze methode, er altijd te achterhalen valt of de video vertrouwd is of van een onbekende uitgever komt.

Het risico is dat uitgevers die niet gebruik maken van de methode eerder en misschien onterecht in twijfel gebracht kunnen worden.

Het is belangrijk dat we – nu werkelijkheid en fantasie steeds slechter uit elkaar te halen zijn - scherp zijn op de mogelijke nadelige gevolgen. De techniek heeft echter niet alleen een destructieve kracht, maar kan ook worden ingezet als creatieve ondersteuning en digitale troost. Hoe dan ook, Pandora’s doos is geopend: deepfake creëert voor ons allemaal een nieuwe realiteit.