In deze explainer onderzoeken we de censuur rondom free speech m.b.t. Gaza en de vage transparantierapporten die platforms als Instagram, TikTok en X hierover publiceren. We leggen uit hoe inzichtelijk deze moderatie echt is en waarom het zo moeilijk blijft om te controleren of gevoelige content bewust onzichtbaar wordt gemaakt.

Dataverantwoording

Hieronder vind je de verantwoording bij ons onderzoek naar de effectiviteit en transparantie van contentmoderatie van grote sociale mediaplatforms (Instagram, TikTok en X) met betrekking tot berichten over Gaza/Palestina. We lichten toe hoe we de praktijktest hebben uitgevoerd, welke data we gebruikten voor de analyse en hoe we kwamen tot onze vijf meetcriteria.

Achtergrond

Sinds de escalatie van het conflict in Gaza melden gebruikers regelmatig dat content over de situatie wordt beperkt, verwijderd of minder zichtbaar gemaakt op platforms als Instagram, TikTok en X. Deze meldingen variëren van verminderd bereik (shadowbanning) tot volledige verwijdering zonder duidelijke motivatie. Tegelijkertijd publiceren de platforms zelf transparantierapporten waarin moderatie activiteiten worden gerapporteerd, maar doorgaans zonder gedetailleerde toelichting op politieke of geopolitieke thematiek. Dat maakt het moeilijk om conclusies te trekken over hoe deze moderatie werkt en hoe transparant deze is voor gebruikers.

Praktijktest: opzet en data

Voor onze analyse voerden we een gecontroleerde praktijktest uit met neutrale, informatieve posts over oorlog die voldeden aan de richtlijnen van de platforms:

- We plaatsten identieke content over Gaza en Israel (zonder expliciet geweld, zonder aanzetten tot haat of oproepen tot actie) op drie platforms: Instagram, TikTok en X.

- We hebben ook op elk platform een neutrale post gemaakt om een goed overzicht te houden van de engagement.

- We hebben alle accounts en posts op een vpn gemaakt en alle posts zijn op hetzelfde moment geplaatst om algoritme invloed van vorige posts te vermijden.

Voor elk geplaatst bericht registreerden we:

- Bereik

- Moderatie acties

- Feedback/meldingen van het platform naar de gebruiker

- Tijdstip en engagementstatistieken

Deze data gaven inzicht in hoe de moderatie in de praktijk uitpakt voor posts over een politiek gevoelig onderwerp.

Analyse van transparantierapporten

Naast de praktijktest analyseerden we de beschikbare transparantierapporten die Instagram, TikTok en X publiceren. We beoordeelden:

- Hoe uitgebreid platforms melden over contentmoderatie activiteiten.

- Of en hoe expliciet zij vermelden welke inhoudstypen zij modereren.

- Het detailniveau van verklaringen over verwijderd of beperkt materiaal.

Deze rapporten vormen de basis voor het criterium “kwaliteit van transparantierapporten” in onze analyse.

Onderzoek vondsten (Visualisatie 1)

In dit onderzoek heb ik gekeken hoe open de drie grote platforms zijn over hun regels, hun algoritmes en hun moderatie.

Hoe heb ik gezocht?

Ik heb de DSA Transparency Database van de Europese Unie gebruikt. Hier moeten platforms verplicht melden waarom ze bepaalde berichten verwijderen.

Daarnaast heb ik de “Transparency Reports” van TikTok, X en Instagram naast elkaar gelegd om te zien wie de meeste details afgeeft.

Mijn bevindingen per platform

- Instagram: De winnaar in transparantie

Instagram scoort in ons overzicht overal groen. Waarom? Omdat ze niet alleen zeggen dat ze modereren, maar ook heel precies uitleggen hoe.

Algoritme: Ze hebben 22 zogenaamde “System Cards” gepubliceerd. Dit zijn ‘kaarten’ waarop wordt uitgelegd waarom jij een bepaalde Reel of post te zien krijgt.

Moderatie: In hun rapporten zie je precies welk percentage door AI is verwijderd en wat door mensen is gedaan.

- TikTok: Goed op weg, maar soms vaag

TikTok doet het op veel vlakken goed. Ze geven onderzoekers toegang tot data (via een API) en laten duidelijke cijfers zien over verwijderde video’s.

Waar TikTok punten laat liggen, is bij Visibility Filtering. Ze leggen wel uit wanneer een video wordt verwijderd, maar zijn vager over waarom een video soms niet op de ‘For You Page’ komt. De regels hiervoor zijn minder inzichtelijk dan bij Instagram.

- X: Niet Transparant

X heeft de code van hun algoritme openbaar hebben gemaakt op GitHub. Toch staan er in mijn tabel vooral gele uitroeptekens. Het grootste probleem is dat X de toegang tot fatsoenlijke data voor onderzoekers achter een paywall zet. Hierdoor is onafhankelijke (gratis) controle bijna onmogelijk.

Conclusie

Er is een groot verschil tussen ‘zeggen dat je transparant bent’ (X) en ‘echt uitleggen hoe het werkt’ (Instagram). Uit de officiële documenten blijkt dat Instagram momenteel de meeste inzage geeft, terwijl X het voor buitenstaanders juist lastiger maakt om mee te kijken.

Aan de hand van de gevonden informatie heb ik een tabel in elkaar gezet met de overzichtelijke data:

| Criterium | TikTok | Instagram (Meta) | X (Twitter) |

| 1. Moderatie (Mens vs. Machine) | Ja (Zeer gedetailleerd) | Ja (Zeer gedetailleerd) | Gedeeltelijk |

| 2. Data voor Onderzoekers | Ja (Research API aanwezig) | Ja (Meta Content Library) | Nee / Zeer Beperkt |

| 3. Algoritme Uitleg | Ja (Technische papers gepubliceerd) | Ja (22 ‘System Cards’ gepubliceerd) | Gedeeltelijk (Code open source, maar verouderd) |

| 4. CIB / Staatsinvloed | Ja (Covert Influence Ops rapporten) | Ja (Quarterly Adversarial Threat Report) | Onduidelijk / Ad hoc |

| 5. Transparantie Visibility filtering |

Gemiddeld | Hoog | Gemiddeld |

Opstellen van de meetcriteria (visualisatie 2)

Op basis van de praktijktest en rapportanalyse hebben we vijf positieve beoordelingscriteria opgesteld waarmee we de platforms vergelijken in de radar chart:

- Moderatie-transparantie: Hoe duidelijk communiceert het platform waarom content gemodereerd is?

- Eerlijke en consistente moderatie: In hoeverre worden vergelijkbare posts op een gelijkwaardige manier behandeld?

- Bereikneutraliteit: In hoeverre blijft het bereik van posts onverklaarbaar neutraal?

- Feedbackkwaliteit: Hoe begrijpelijk en behulpzaam zijn de meldingen die gebruikers krijgen?

- Rapportkwaliteit: Hoe gedetailleerd, begrijpelijk en bruikbaar zijn de transparantierapporten?

Deze criteria zijn gekozen omdat ze zowel gebruikerservaring als institutionele communicatie omvatten, en omdat ze meetbaar zijn met de data uit onze test en de openbare documenten van de platforms.

Beperkingen

Er zijn beperkingen aan dit onderzoek:

- De praktijktest is kleinschalig en beperkt representatief voor alle gebruikers en omstandigheden.

- Algoritmische moderatie is een black box: zonder toegang tot interne data van de platforms kunnen we geen sluitende verklaringen geven over waarom bepaalde posts anders presteren.

- Platforms kunnen updates hebben doorgevoerd tijdens de testperiode.

Daarom zijn de uitkomsten vooral indicatief en bedoeld om relatieve verschillen en patronen zichtbaar te maken.

Door praktische testdata en transparantiedocumenten te combineren met duidelijke beoordelingscriteria geven we een zo eerlijk mogelijk beeld van moderatiepraktijken rond Gaza gerelateerde content op sociale media. De radar chart is een visuele weergave van deze vergelijking en helpt om inzichtelijk te maken op welke punten de platforms sterker of zwakker scoren in transparantie en eerlijke moderatie.

Bronnen

NOS Nieuwsuur

NOS. (2024). Verantwoording en bronnen bij Ophef-aflevering over de algoritmes van Instagram en TikTok.

Artikel waarin Nieuwsuur toelicht hoe het onderzoek naar algoritmes en platformtests is uitgevoerd.

https://nos.nl/nieuwsuur/collectie/13903/artikel/2519039-verantwoording-en-bronnen-bij-ophef-aflevering-over-de-algoritmes-van-instagram-en-tiktok

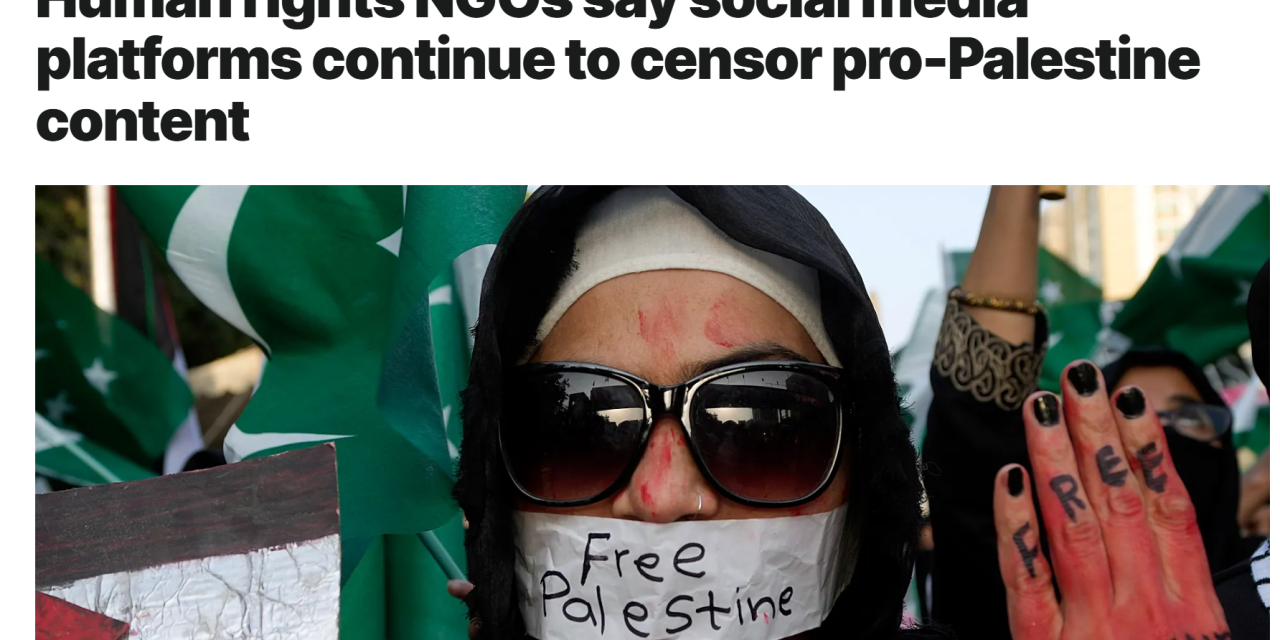

Euronews

Euronews. (2024, 7 oktober). Human rights NGOs say social media platforms continue to censor Palestinian content.

Artikel waarin mensenrechtenorganisaties hun zorgen uiten over de moderatie van Gaza-gerelateerde content op sociale mediaplatforms.

https://www.euronews.com/next/2024/10/07/human-rights-ngos-say-social-media-platforms-continue-to-censor-palestinian-content

Human Rights Watch (HRW)

Human Rights Watch. (z.d.). Rapporten over digitale rechten en contentmoderatie.

HRW publiceert meerdere onderzoeken naar systematische beperking van Palestijnse content op socialmediaplatforms.

https://www.hrw.org

7amleh – Arab Center for the Advancement of Social Media

7amleh. (z.d.). Home.

Niet-gouvernementele organisatie die Palestijnse digitale rechten monitort en rapporteert over online censuur en platformbeleid.

https://7amleh.org

The Markup

The Markup. (2024). Demoted, Deleted, and Denied: There’s More Than Just Shadowbanning on Instagram.

Onderzoeksjournalistiek artikel over het verlagen, verwijderen en blokkeren van bezwaarprocedures bij Gaza-gerelateerde content op Instagram.

https://themarkup.org

TikTok – Digital Services Act-documentatie

TikTok. (2025). DSA Transparency Documentation (H1 2025).

Officiële documentatie gepubliceerd in het kader van de Europese Digital Services Act, met cijfers over contentmoderatie en handhaving.

https://sf16-va.tiktokcdn.com

X

X Corp. (2025, 18 november). 2025 Transparency Report.

Officieel transparantierapport van X over contentmoderatie, verwijderingen en handhaving van richtlijnen.

https://transparency.x.com/en

TikTok Transparantiecentrum

TikTok. (2025). Transparantiecentrum.

Publiek toegankelijke informatie over TikToks moderatiebeleid, richtlijnen en handhavingsrapportages.

https://www.tiktok.com/transparency/en

Meta – Transparency Reports

Meta. (z.d.). Transparency Reports.

Rapporten over Community Standards Enforcement, inclusief data over AI-verwijderingen en dreigingsrapportages.

https://transparency.meta.com/reports/

Europese Commissie – DSA Transparency Database

Europese Commissie. (z.d.). DSA Transparency Database.

Database met ‘Statements of Reasons’ waarin wordt vastgelegd waarom content is verwijderd; filterbaar per platform.

https://transparency.dsa.ec.europa.eu/

Meta – System Cards

Meta. (z.d.). System Cards.

Technische documentatie over hoe Instagram Feed en Reels functioneren, inclusief ranking- en aanbevelingssystemen.

https://ai.meta.com/tools/system-cards/

TikTok Newsroom

TikTok. (z.d.). How TikTok recommends videos #ForYou.

Uitleg van TikTok over de basisprincipes achter het aanbevelingsalgoritme.

https://newsroom.tiktok.com/how-tiktok-recommends-videos-for-you?lang=en

TikTok Support

TikTok. (z.d.). Content violations and bans.

Overzicht van richtlijnen over overtredingen, sancties en accountbeperkingen.

https://support.tiktok.com/en/safety-hc/account-and-user-safety/content-violations-and-bans

X Developer Platform

X Corp. (z.d.). X API v2 – Introduction.

Documentatie waaruit blijkt dat toegang tot leesdata voor onderzoek grotendeels achter betaalde pakketten zit.

https://docs.x.com/x-api/introduction

GitHub – X Recommendation Algorithm

Twitter. (z.d.). GitHub – twitter/the-algorithm: Source code for the X Recommendation Algorithm.

Gedeelde broncode van het aanbevelingsalgoritme, zonder actuele instellingen (‘weights’) beperkt inzichtelijk.

https://github.com/twitter/the-algorithm\